Introdução:

Os Transformers são uma classe de modelos de aprendizado de máquina que revolucionou a inteligência artificial nos últimos anos. Transformers trouxeram uma abordagem radicalmente nova para a compreensão de texto e outras tarefas de processamento de linguagem natural (PLN). Neste texto, mergulharemos na arquitetura dos Transformers, suas principais características e como eles superaram algumas das limitações dos modelos tradicionais, abrindo caminho para uma nova era de aplicações inteligentes.

A Motivação para os Transformers:

Antes do surgimento dos Transformers, muitos modelos de PLN baseavam-se em arquiteturas como redes neurais recorrentes (RNNs) e redes neurais convolucionais (CNNs). Essas abordagens tiveram sucesso em algumas tarefas, mas enfrentaram desafios quando se tratava de lidar com sequências longas, como textos completos. Além disso, essas arquiteturas eram computacionalmente intensivas e tinham dificuldades em aprender relações de longo alcance em sequências.

Os pesquisadores perceberam que as RNNs e CNNs dependiam fortemente de uma ordem fixa de palavras na entrada, tornando-as ineficientes para capturar conexões significativas entre palavras distantes. Os Transformers abordaram essa limitação com um mecanismo inovador de atenção, permitindo que os modelos aprendessem a importância relativa das palavras em uma sequência, sem depender de sua posição fixa.

O Conceito de Atenção:

O coração dos Transformers é o mecanismo de atenção. A atenção é uma técnica que permite que o modelo se concentre em partes específicas de uma sequência ao calcular uma média ponderada das representações de todas as palavras na sequência. A importância de cada palavra é determinada por um valor de atenção, que é aprendido durante o treinamento.

Para entender como a atenção funciona, imagine que estamos traduzindo uma frase do inglês para o francês. Em vez de ler a frase toda de uma vez e traduzi-la automaticamente, a atenção permite que o modelo selecione as palavras-chave em inglês relevantes para cada palavra em francês. Dessa forma, o modelo pode entender melhor as nuances de cada idioma e produzir uma tradução mais precisa.

Arquitetura dos Transformers:

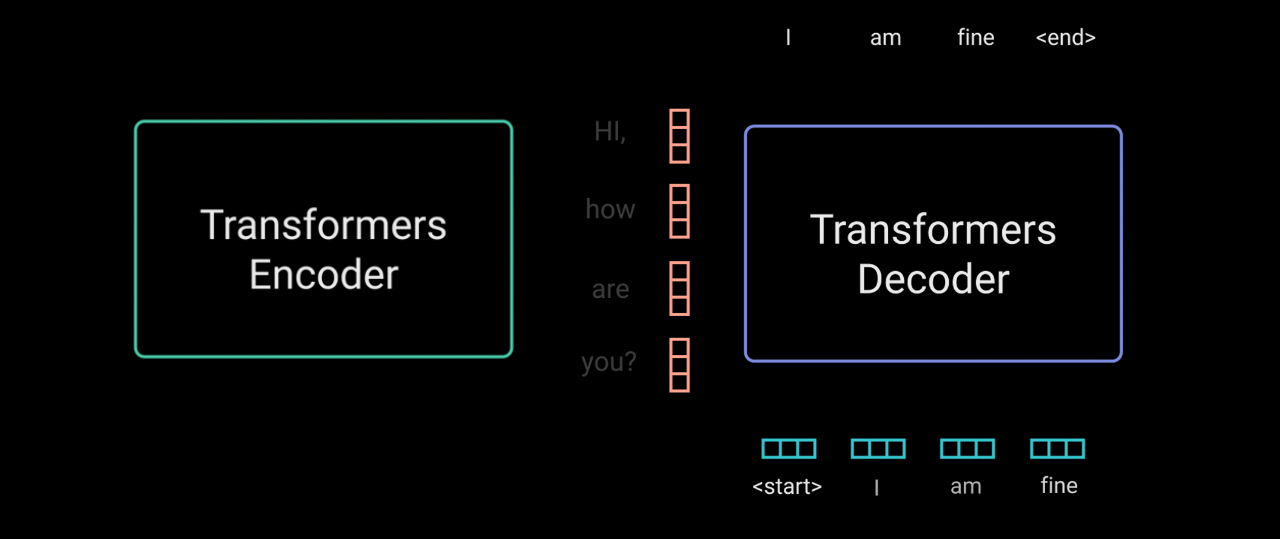

A arquitetura dos Transformers é dividida em dois componentes principais: o codificador (encoder) e o decodificador (decoder). Essa estrutura foi inicialmente projetada para tarefas de tradução automática, mas logo se mostrou eficaz em muitas outras tarefas de PLN, como resumo de texto, geração de texto e classificação de sentimentos.

O codificador é responsável por aprender representações de alta qualidade da sequência de entrada. Cada palavra ou token na sequência é representado por um vetor de números (embedding). Em seguida, várias camadas de codificação, chamadas de blocos de atenção, são empilhadas. Cada bloco de atenção possui várias cabeças de atenção que aprendem padrões diferentes da sequência. Essa abordagem permite que o modelo capture informações contextuais de maneira mais eficiente e com menos parâmetros do que outras arquiteturas, como as RNNs.

O decodificador é usado em tarefas de geração de texto, onde o modelo produz uma sequência de saída. Ele também utiliza blocos de atenção, mas com algumas modificações para garantir que a geração seja feita de forma autoregressiva, ou seja, uma palavra de cada vez, dependendo das palavras geradas anteriormente.

Aplicações dos Transformers:

Os Transformers revolucionaram as tarefas de PLN e são amplamente utilizados em diversas aplicações. Eles impulsionaram o sucesso de assistentes virtuais, como a Alexa da Amazon e a Siri da Apple, tornando a interação homem-máquina mais natural e eficiente. Também são amplamente usados em motores de busca, melhorando os resultados de pesquisa e a compreensão das consultas dos usuários.

Além disso, os Transformers tiveram um impacto significativo na tradução automática, tornando as traduções mais precisas e fluentes. Em áreas como análise de sentimentos, os Transformers mostraram desempenho superior, capturando melhor as nuances do sentimento humano em textos.

Desafios e Futuro dos Transformers:

Apesar de seu sucesso, os Transformers ainda enfrentam desafios significativos. A principal questão é o alto consumo de recursos computacionais, o que torna a utilização de modelos de grande escala caro e inviável para muitas organizações. Pesquisadores estão trabalhando em técnicas de compressão e otimização para tornar os Transformers mais eficientes.

Outra área de pesquisa promissora é a interpretabilidade dos modelos. Como os Transformers são capazes de aprender padrões complexos e representações abstratas, entender as decisões que eles tomam em tarefas específicas pode ser desafiador. A interpretabilidade é uma preocupação crucial em aplicações de IA em setores como saúde e justiça, onde as decisões precisam ser transparentes e justificáveis.

Conclusão:

Os Transformers são uma das inovações mais significativas na inteligência artificial moderna. Sua arquitetura baseada em atenção trouxe uma abordagem mais flexível e eficiente para o processamento de linguagem natural, permitindo que modelos aprendam relações de longo alcance e representações contextuais em sequências de texto. Essa tecnologia tem sido amplamente adotada em várias aplicações, tornando-se um pilar da IA contemporânea.

No entanto, ainda há muito a ser explorado e aprimorado nos Transformers. A comunidade de pesquisa continua trabalhando arduamente para tornar esses modelos mais eficientes, interpretáveis e responsáveis. À medida que avançamos para o futuro, a expectativa é que os Transformers continuem a moldar a IA e impulsionar inovações em uma ampla gama de setores, tornando-se uma ferramenta cada vez mais poderosa para compreender e interagir com o mundo ao nosso redor.